Model Context Protocol & AAIF: Die neue Infrastruktur für Enterprise-AI-Agenten

Executive Summary

Die Linux Foundation gründet die Agentic AI Foundation (AAIF) – ein Wendepunkt für die Industrie. Anthropic, OpenAI und Block übergeben ihre Kernprotokolle in eine neutrale, offene Governance: Anthropics Model Context Protocol (MCP), OpenAIs AGENTS.md und Blocks Goose.

Das ist nicht einfach nur „noch eine Linux Foundation Initiative“ – das ist die De-facto-Standardisierung für die nächste Welle autonomer AI-Systeme.

MCP löst ein uraltes Problem: den Datensilo-Horror. Statt Custom-Integrationen für jede Kombination aus AI-Modell und Datenquelle (das N×M-Problem) gibt es jetzt einen USB-C-Standard für KI. Für Unternehmen bedeutet das: sichere, skalierbare, herstellerunabhängige AI-Agenten. Für Entwickler: weniger Boilerplate, mehr Innovation.

Der Kontext: Die Datensilo-Krise der AI

Lange Zeit war die Narrative simpel: „Macht euer Modell größer, bessere Weights, mehr Training.“ Alle investierten in Model Capacity. Doch im echten Unternehmen entstand ein altbekanntes Problem: Die beste KI nützt nichts, wenn sie blind sitzt.

Ein Analyst fragt seinen AI-Assistenten: „Wie viele Deals waren dieses Quartal über 1 Mio. USD, mit Kundensektor ‚Tech‘, die nach Q3 closed?“ Das KI-Modell könnte das beantworten – wenn die Daten aus Salesforce, ERP, Finance-DB und CRM nicht in vier verschiedenen Silos säßen. Die klassische IT-Antwort: „Wir bauen dir eine Integration.“ Das dauert Wochen, kostet fünfstellig und nach drei Monaten ist die API veraltet.

Das ist das N×M-Problem: M Datenquellen, N AI-Systeme = M×N maßgeschneiderte Integrationen. Irgendwann bricht das Modell.

Enter: Model Context Protocol

2024 hat Anthropic das Model Context Protocol (MCP) nicht als „Feature“ gelauncht, sondern als „USB-C für AI“. Statt für jedes LLM eine eigene Integration zu bauen, gibt es ein gemeinsames Protokoll. Ein MCP-Server ähnelt einem API-Endpunkt – aber für Kontext. Ein MCP-Client (z.B. Claude, ChatGPT, Cursor) kann sich daran anschließen.

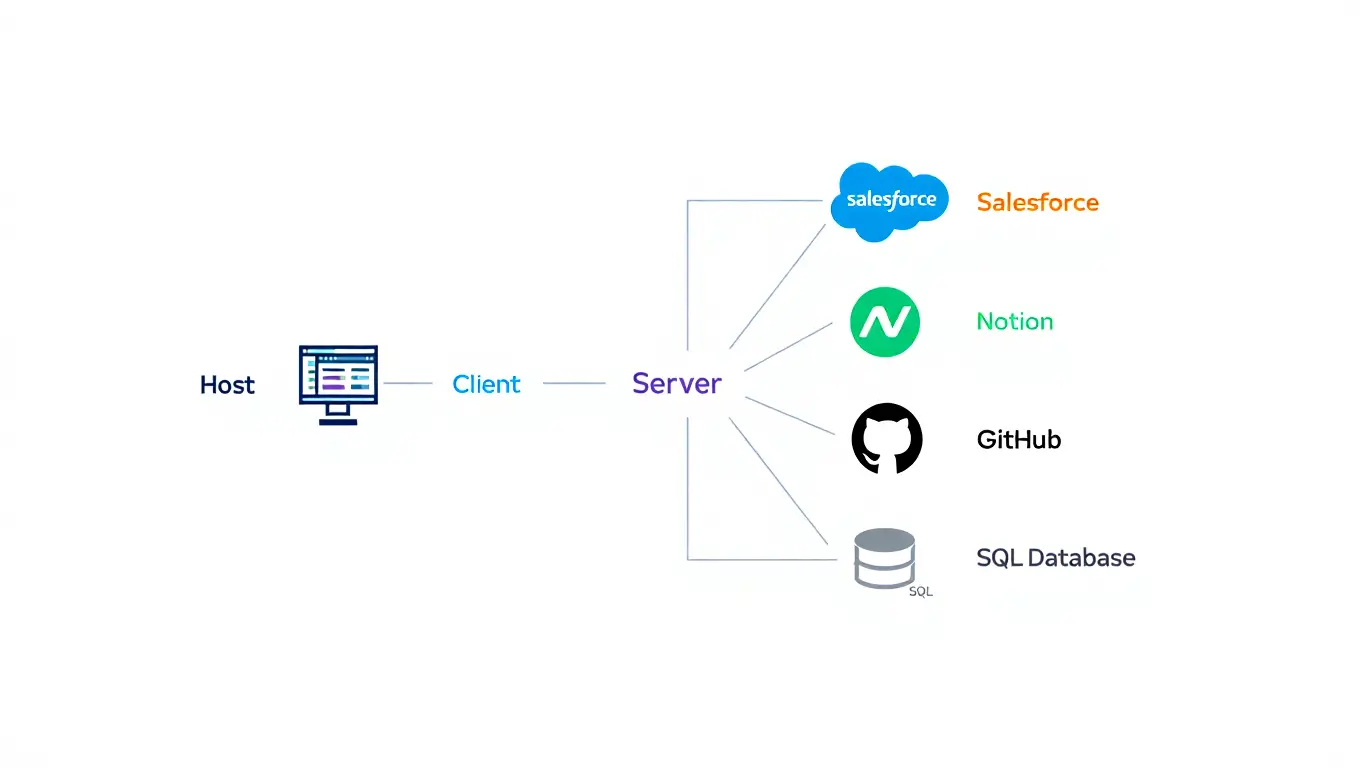

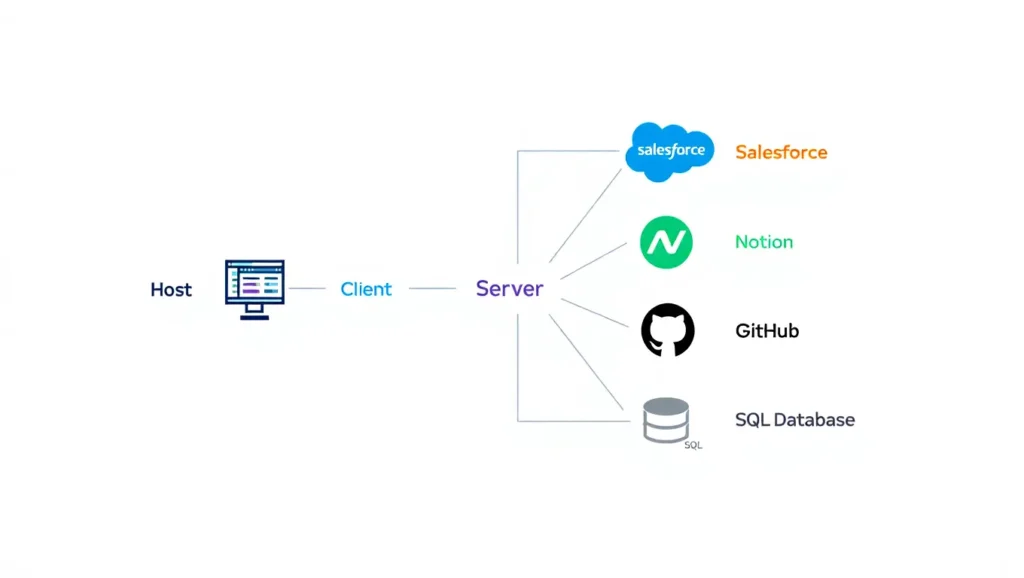

Wie MCP in der Praxis funktioniert:

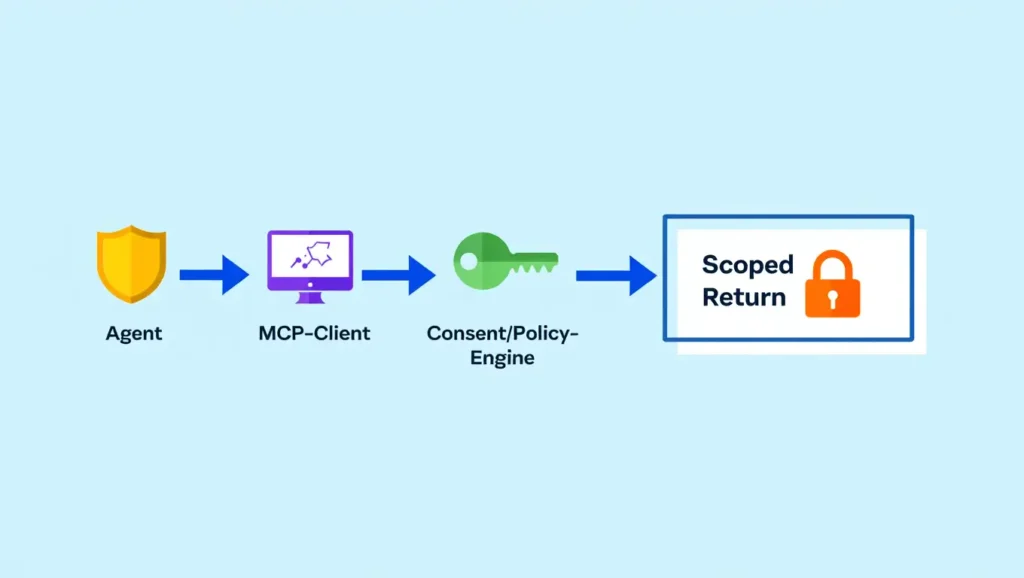

- Host-Applikation: etwa Claude Desktop, Cursor IDE oder ein eigener Enterprise-Agent.

- MCP-Client: die Schicht, die mit MCP-Servern spricht.

- MCP-Server: abstrahiert Datenquellen wie Salesforce, SQL-Datenbanken oder lokale Dateien.

- Standardisierte Kommunikation: Nachrichten über JSON-RPC.

Ergebnis: Der Agent fragt beispielsweise „Zeige mir alle offenen Opportunities in EMEA mit ≥90 % Abschlusswahrscheinlichkeit“ – und der MCP-Server liefert strukturierte Daten zurück. Jeder kompatible Client kann diesen Server nutzen, egal ob OpenAI oder Anthropic dahinter steht.

Die AAIF: Governance als Wettbewerbsvorteil

MCP war ursprünglich ein Projekt von Anthropic. Spannend, aber heikel: Kaum ein Konzern baut seine Kernarchitektur freiwillig auf einem proprietär kontrollierten Protokoll auf.

Im Dezember 2025 gründet die Linux Foundation die Agentic AI Foundation (AAIF). Die Idee: ein vendor-neutrales Zuhause für Standards rund um AI-Agenten.

Kernakteure:

- Anthropic: bringt MCP ein

- OpenAI: bringt AGENTS.md ein

- Block: bringt Goose ein

- Platinum Members:

AWS,

Google Cloud,

Microsoft,

Bloomberg,

Cloudflare

Damit wechselt MCP von „Produkt einer Firma“ zu „gemeinsam verwaltetem Standard“ – ähnlich wie Kubernetes oder HTTP unter der IETF.

Das ist klassischer B2B-Realismus: Wenn alle allein verlieren, gewinnt der gemeinsame Standard.

Was ändert sich praktisch?

Für Entwickler:

- Sie schreiben MCP-Server, nicht 5 verschiedene Integrationen pro LLM.

- Ein Plugin für Cursor kann auch mit Claude Desktop sprechen – beide sprechen MCP.

- Die Community pflegt eine wachsende Registry von MCP-Servern.

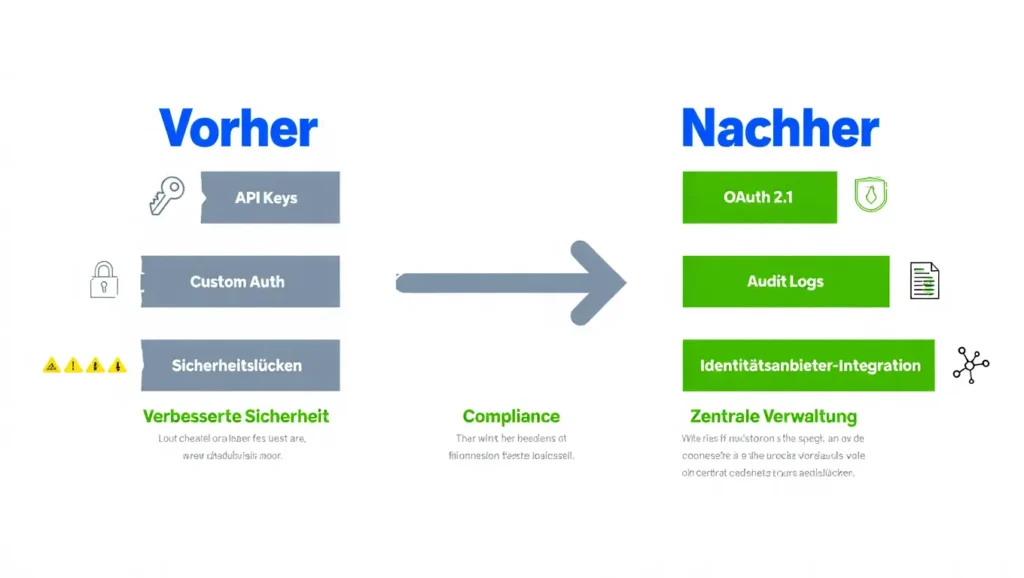

Für Sicherheit & Compliance:

- Die MCP-Spezifikation fordert expliziten User-Consent für Datenzugriffe.

- Data Privacy und Tool Safety sind definierte Ziele, nicht optional.

- Zero-Trust: Keine impliziten Rechte, jeder Zugriff muss begründet und genehmigt sein.

Sicherheit wandert damit von „individueller Implementierungsdetails“ in die „Standard-Schicht“. Genau das fehlte, um AI-Agenten in regulierten Branchen ernsthaft zu platzieren.

Real-World Use Cases

Block + DataHub: Metadata als Governance-Layer

Block (u.a. Square, Cash App) betreibt dutzende Dataplattformen. Mit dem AI-Agent Goose und einem DataHub MCP-Server können Engineers Fragen stellen wie:

„Welche Dashboards brechen, wenn ich die Tabelle customer_events ändere?“

Goose analysiert Lineage, Ownership und Abhängigkeiten über MCP – ohne manuelle SQL-Orgien oder IT-Tickets. Das ist Governance as a Service.

Cursor + Claude: IDE meets LLM

Cursor ist ein AI-first Code Editor mit nativer Claude-Integration. Über MCP kann Claude:

- lokale Dateien lesen

- GitHub-Repos analysieren

- mit Docker-Containern interagieren

Das Modell „phantasiert“ nicht mehr über Code, sondern arbeitet auf echtem Kontext.

Microsoft Copilot & Enterprise-Integration

Microsoft integriert MCP in seine Copilot-Strategie. Perspektivisch können Agenten so auf Outlook, SharePoint und Teams zugreifen – gesteuert über MCP-Server und Policies statt Custom-Integrationen.

Die versteckte Realität: Wer gewinnt?

Anthropic: Mit Claude und MCP positioniert sich Anthropic als Plattform, nicht nur als Modellanbieter.

OpenAI: Mit AGENTS.md sitzt OpenAI am Agenten-Format mit am Tisch der Standardisierung.

Hyperscaler (AWS, Google, Microsoft): Sie gewinnen, weil sie ihre Services über MCP-Server andocken können, ohne die Kontrolle über den Agenten selbst behalten zu müssen.

Startups: Player wie Goose, Cursor oder DataHub bauen auf dem Standard auf – innovativ, aber nicht abhängig von einem einzelnen LLM-Vendor.

Enterprise mit Legacy: Statt bei jedem Vendor eine neue Integration zu kaufen, können sie auf eine wachsende Library von MCP-Servern setzen. Das senkt Integrationskosten und reduziert Vendor-Lock-in.

Das Sicherheits-Skeptiker-Argument

Der typische CTO fragt: „Verbinden wir hier wirklich AI-Agenten direkt mit Salesforce, ERP und Finance-Systemen? Wer kontrolliert, was der Agent sieht?“

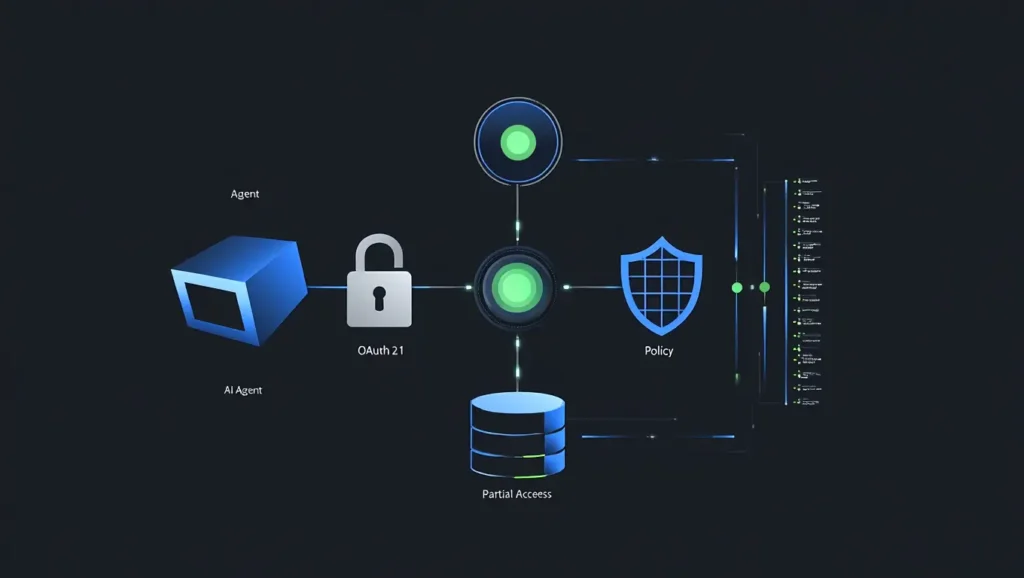

Die MCP-Spezifikation adressiert genau das:

- User Consent & Control: Nutzer müssen Zugriffe explizit freigeben.

- Scoped Access: Ein MCP-Server kann sehr granular eingeschränkt werden (z.B. nur „EMEA Opportunities“, nicht „alle Deals“).

- Audit Logging: Jeder Zugriff kann geloggt und nachverfolgt werden.

- Identity-Based Access: Agenten agieren mit technisch minimierten Service-Identitäten, nicht mit Admin-Rechten.

Das ist eher „Read-only API User mit Logging“ als „allmächtige Super-KI“.

Der Weg nach vorne: Praktische Roadmap

Nächste 6 Monate (bis Juni 2026):

- AAIF stabilisiert MCP-Version 2.x.

- Weitere Enterprise-MCP-Server (SAP, Oracle, Workday) tauchen auf.

- Erste Zertifizierungen und Best Practices für regulierte Branchen.

- MCP Dev Summit North America 2026 als Katalysator für das Ökosystem.

6–12 Monate:

- MCP wird für große SaaS-Anbieter „Must-have“.

- Governance-Tools entstehen (Wer darf welche Agenten mit welchen Servern kombinieren?).

- Erste klare regulatorische Leitplanken für AI-Agenten in Finance und Health.

Langfristig (2027+):

- MCP etabliert sich als De-facto-Standard, ähnlich wie HTTP fürs Web.

- Neue Rollen entstehen („MCP Architect“, „Agent Orchestrator“).

- AI-Integration wird von „Projektgeschäft“ zu „Plattformbetrieb“.

FAQ

F1: Ist MCP dasselbe wie eine REST API?

Nein. REST ist für klassische Request-Response-Muster gebaut. MCP ist für agentisches Kontext-Sharing optimiert. REST: Der Client weiß genau, welche Ressource er abruft. MCP: Der Agent bekommt über Resources, Tools und Prompts den Kontext, den er für intelligente Aktionen braucht.

F2: Ist MCP open-source? Wem gehört es?

Ja. MCP ist unter Apache-2.0-Lizenz open-source und lebt in der GitHub-Organisation Model Context Protocol. Mit der AAIF liegt die Governance bei der Linux Foundation und einem Multi-Stakeholder-Board.

F3: Wann kann mein Unternehmen damit live gehen?

Jetzt für Pilots, ab 2026 für harte Produktion. Mit Claude Desktop und bestehenden MCP-Servern (z.B. für Notion, GitHub, Slack-Integrationen) können Unternehmen heute schon interne PoCs aufsetzen. Für hochsensible Szenarien (Finance, Health) ist eine strukturierte Einführung mit Governance und Security-Review ab 2026 sinnvoll.

F4: Brauchen wir MCP oder reicht RAG (Retrieval Augmented Generation)?

Beides – aber für unterschiedliche Aufgaben. RAG eignet sich für Wissensbestände (Dokumentation, historische Daten), die als Vektoren indexiert werden. MCP ist für Live-Daten und Aktionen: aktuelle Preise, Lagerbestände, Workflows in Salesforce, Ticket-Erstellung, Freigaben. In einer modernen Architektur ergänzen sich RAG und MCP.

Fazit: Die Marc-Juncke-Perspektive

Das AAIF-Ökosystem ist der nächste Schritt in der Industrialisierung von AI-Agenten.

Strategisch (CEO-Brille):

MCP und AAIF senden das Signal: „Agentic AI geht von Experiment zu Infrastruktur.“

Vendor-Neutralität reduziert das Risiko von Fehlinvestitionen massiv.

Wer jetzt Know-how aufbaut, verschafft sich einen echten Vorsprung.

Pragmatisch (IT-Realitätscheck):

Sicherheit, Consent und Logging sind im Standard verankert.

Trotzdem bleibt: MCP ist ein mächtiges Werkzeug, kein Selbstläufer.

Die Kunst liegt im sauberen Design der Server, Policies und Rechte.

Innovativ (Hands-on):

Empfehlung: Klein starten – mit

Claude Desktop und ein, zwei internen MCP-Servern.

Schnell lernen, was für das eigene Unternehmen wirklich Mehrwert stiftet.

Brückenbauer (Business ↔ Technik):

Dem CFO lässt sich sagen: „MCP senkt die Integrationskosten und vermeidet Lock-in.“

Dem CTO: „Wir bauen auf einen offenen Standard, nicht auf Insellösungen.“

Dem Datenschutz: „User Consent + Audit Logging = kontrollierbare Risiken statt blindem Wildwuchs.“

Die Gewinner dieser Welle werden nicht die sein, die die „beste KI“ einkaufen, sondern die, die sie am sichersten, produktivsten und unabhängigsten in ihre Prozesse integrieren. MCP und AAIF sind dafür die neue Basis-Infrastruktur.

Keywords & Hashtags

SEO Keywords

- Model Context Protocol (MCP)

- Agentic AI Foundation (AAIF)

- AI Agents Enterprise

- Data Integration Standard

- LLM Context Management

- AI Governance Framework

- Open Source AI Standard

- Anthropic MCP

- AI Interoperability

- Datensilo-Problem

- Claude Desktop

- Cursor IDE

- Goose AI Agent

Hashtags

#MCP #AAIF #AgenticAI #AIAgents #ModelContextProtocol #OpenAI #Anthropic #Block #LinuxFoundation #AIGovernance #EnterpriseAI #DataIntegration #AIStandards #AIInfrastructure #LLM

5 Key Takeaways

1. AAIF ist der Governance-Sieg, den Enterprise brauchte

OpenAI,

Anthropic und

Block spenden ihre Kernprodukte in eine neutrale Foundation.

Das sendet ein klares Signal: Diese Standards werden nicht von einer einzelnen Firma kontrolliert.

Für Unternehmen heißt das: Kein Vendor-Lock-in, echte Investitionssicherheit.

Die AAIF wird von der

Linux Foundation verwaltet – derselben Institution, die auch Linux und Kubernetes stewarded.

2. Das N×M-Integrationsproblem wird finally gelöst

Vor MCP: 50 verschiedene Datenquellen × 10 AI-Modelle = 500 Custom-Integrationen.

Nach MCP: Ein Standard, alle Kombinationen funktionieren. Das ist wirtschaftlich enorm – spart Entwicklerjahre und Wartungskosten.

3. MCP ist jetzt Enterprise-Grade (nicht nur Developer-Spielzeug)

Das MCP-Spec-Update 2025 bringt klare Anforderungen an Sicherheit, User-Consent und Tool-Safety.

Mit der wachsenden Zahl von MCP-Servern ist das Ökosystem produktiv und nicht mehr nur Experimentierfläche für Early Adopter.

4. Sicherheit ist jetzt Teil des Protokolls, nicht Afterthought

Die MCP-Spezifikation schreibt „User consent and control“, „data privacy“ und „tool safety“ als Kernprinzipien fest.

Unternehmen können damit Governance und Compliance direkt auf Protokollebene verankern, statt Sicherheit nachträglich in jeden einzelnen Agent zu frickeln.

5. Das Web-Modell wiederholt sich (dieses Mal mit AI)

HTTP machte das Web interoperabel.

MCP und die

AAIF zielen auf das Gleiche für AI-Agenten.

Die frühe Adoption durch Cursor,

Claude,

Microsoft und andere ist ein starkes Signal.

Publiziert: 11. Dezember 2025

Autor: Marc Juncke, C-Level IT-Strategist (25+ Jahre)

Websites: www.juncke.com